1 - 2 신경망의 기본구조

앞의 글에서는 신경망의 기본구조 중 퍼셉트론(perceptron)과 단층 신경망 (single layer neural network)에 대해서 다뤘다. 퍼셉트론(perceptron)은 입력층(input layer) 하나와 출력층(output layer) 하나로 구성되며, 출력층(output layer)이 유일한 계산층이다. 사용자는 모든 계산 결과를 직접 볼 수 있다.

2020/03/06 - [AI/Neural Networks Study] - Chapter 1. 신경망 입문(Neural network) - 1 (퍼셉트론, single-layer)

Chapter 1. 신경망 입문(Neural network) - 1 (퍼셉트론, single-layer)

- 1-1. Introduction - 1-2. 기본 구조. - 퍼셉트론(Perceptron) 본 카테고리의 글들은 책. <신경망과 심층학습 Neural Networks and Deep Learning> / 차루 C. 아가르왈 지음. 류광 옮김. Jpub 출판. 을 바탕으로..

supermemi.tistory.com

이번 글에서는 다층신경망에 대해서 다룬다.

2. 다층 신경망(multi layer)

계산층이 둘 이상인 신경망을 다층(multi layer) 신경망이라고 부른다.

- 용어정리 by

- Input Layer (입력층) : 데이터가 입력되는 계층 (가지돌기의 역할)

- Hidden Layer (은닉층) : 데이터가 전달되는 계층 (뉴런-시냅스-축삭돌기-뉴런 등 신호의 전달 계층)

- Output Layer (출력층) : 데이터가 출력되는 계층 (운동기관을 통해 반응여부를 결정하는 기능)

- Units : 데이터를 받아들여 다음 계층으로 전달할지 판단 (신경망 뉴런의 역할)

- Weights : 전/후 Units를 잇는 화살표, 각 Units의 연결강도를 결정하는 가중치 (시냅스 틈을 타고 전달되는 신경 전달 물질의 강도, 특정 감각에 대하여 민감한지 둔감한지 여부)

- Activation (Function) : Units에서 다음 신호로 보낼지 판별하는 함수 (뉴런에서 계산된 값이 임계치를 넘는지 여부와 이를 토대로 다음 신호 전달여부를 활성화 할 것인지 판단)

https://joohyoung.net/chapter-1-introduction-to-dl/

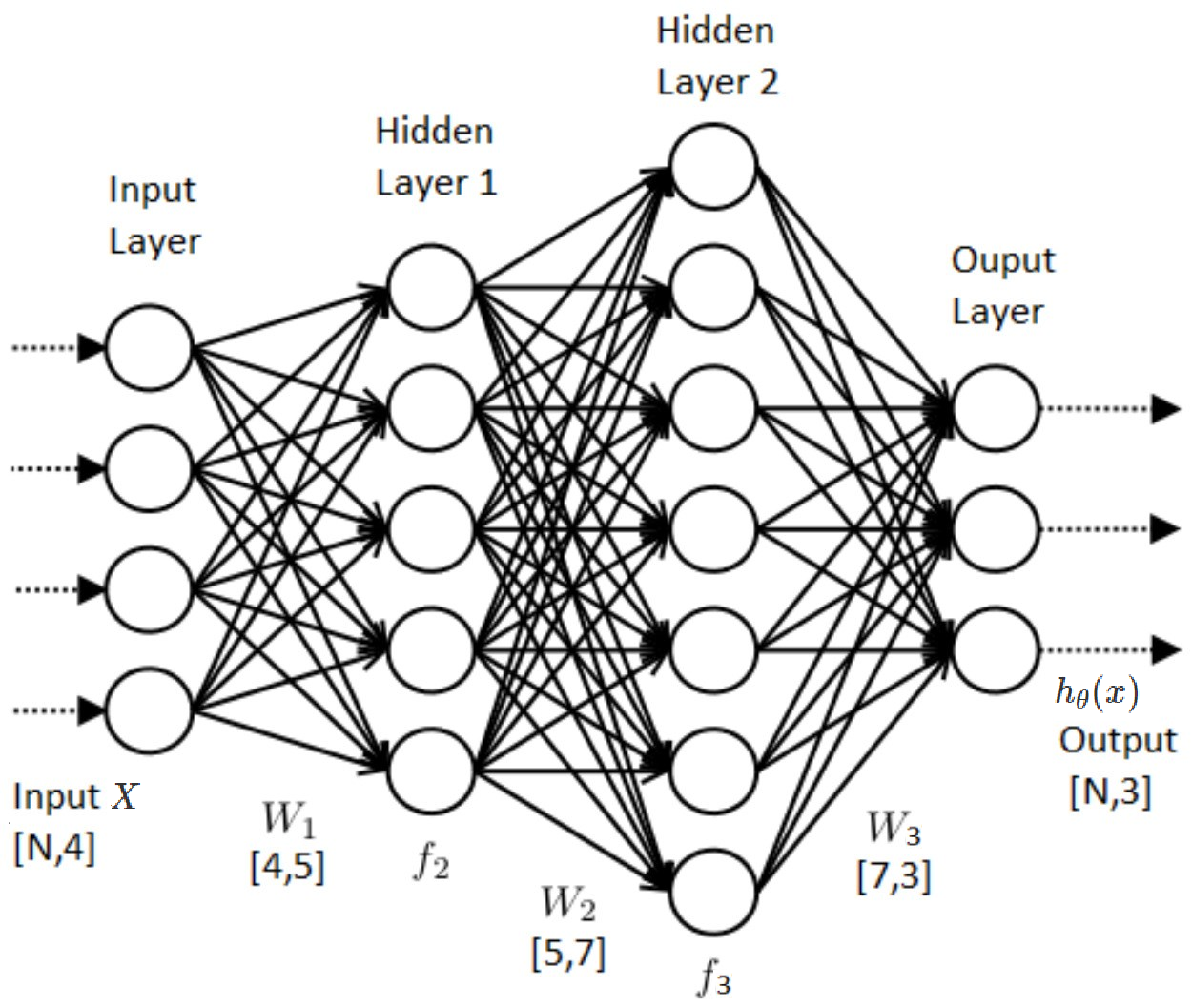

다층 신경망(multi layer NN)은 계산층이 여러 개이며, 추가적인 중간 계산층(입력과 출력 사이의)을 은닉층(hidden layer)이라고 부른다. 이 hidden layer의 계산 층을 사용자가 볼 수 없기 때문에 그런 이름이 붙었다고한다. 입력층(input layer)은 그냥 자료를 전달하기만 할 뿐 그 어떤 계산도 수행하지 않으므로 층수에 포함하지 않을 때가 많음을 주의한다. 위 사진의 구조는 3 layer이다. (hidden layer의 수 + output layer의 수)

모든 계산층이 자신의 계산 결과를 입력에서 출력으로의 순방향으로만 전달하는 구조를 따르는 다층 신경망을 순방향 신경망(feed-forward network)이라고 부른다. 이러한 기본적 형태의 순방향 신경망에서, 한 층의 모든 노드는 그 다음 층의 모든 노드와 연결된다.

따라서, 이런 종류의 신경망에서는 층의 수와 각 층의 노드 종류 및 수만 결정되면 신경망의 전체 구조가 완전히 정의 되고, 마지막으로 출력층(output layer)에서 최적화할 손실함수가 무엇인지만 결정하면된다.

신경망의 층의 수 : k

한층을 구성하는 계산 단위 : p_1, ... , p_k

신경망의 출력 : 열벡터 h_1, ... , h_k

가중치 size :

W_1 : (input layer vector dimension) * p_1

W_r+1 : p_r * p_(r+1)

행렬로 수치들을 생각해 보면, 구조를 잘 파악해야한다. 위 그림을 예로들어 설명하겠다.

신경망의 층의 수는 : 3

한층을 구성하는 계산 단위 : 5, 7, 3

신경망의 출력 열벡터 : h_1, h_2, h_3

출력 열 벡터의 차원은 각 층의 계산 단위와 같다.

가중치행렬의 size

W_1 : 4 * 5

W_2 : 5 * 7

W_3 : 7 * 3

출처

https://joohyoung.net/chapter-1-introduction-to-dl/

신경망과 심층학습/차루 c. 아가르왈/류광 옮김/jpub출판/

'Artificial Intelligence > Basic' 카테고리의 다른 글

| A Beginner's Guide to Variational Methods: Mean-Field Approximation (0) | 2022.02.13 |

|---|---|

| 용어 정리 (인공지능, 머신러닝, 컴퓨터비전 분야) (0) | 2022.01.17 |

| 머신 러닝(Machine learning)이란 무엇인가? (supervised? or unsupervised?) (0) | 2020.03.21 |

| Chapter 1 - 1 퍼셉트론(Perceptron), single layer (0) | 2020.03.06 |

| Mnist / Neural Net / Relu by jupyter (0) | 2020.03.05 |